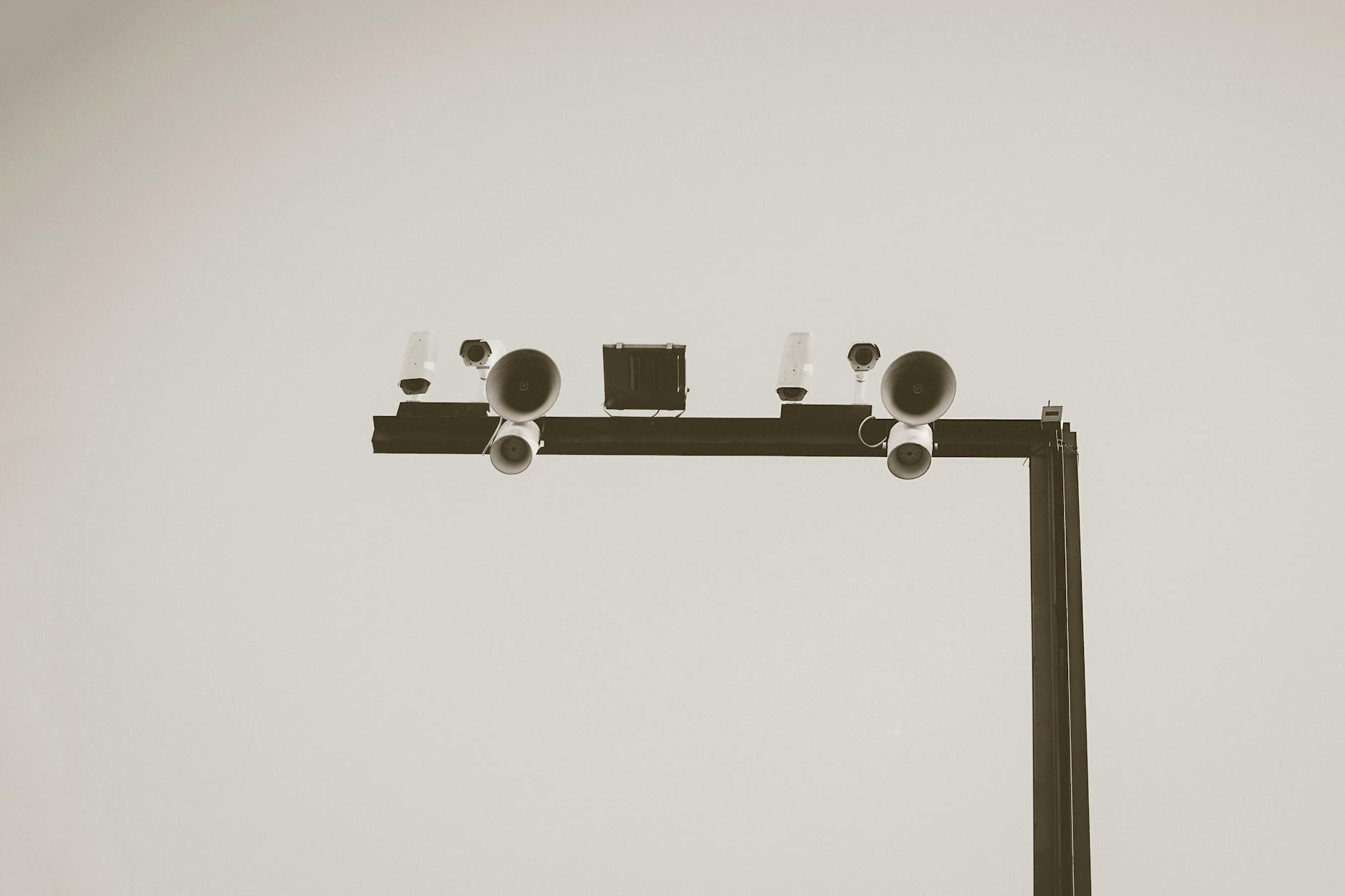

Od monitoringu „nagrywającego wszystko” do systemów, które same wyłapują zdarzenia

W wielu firmach monitoring wizyjny nadal działa jak elektroniczna czarna skrzynka: wszystko się nagrywa, ale ktoś zagląda do materiału dopiero po kradzieży, wypadku albo sporze z pracownikiem. Taki model daje dowody, lecz nie zapobiega incydentom. Sztuczna inteligencja przesuwa ciężar z pasywnego rejestrowania na aktywną analizę obrazu w czasie rzeczywistym, gdzie kluczowe jest wykrywanie nietypowych zdarzeń, zanim rozrosną się do poważnego problemu.

Same kamery HD, nawet z perfekcyjną optyką, nie zwiększą bezpieczeństwa, jeśli nikt nie jest w stanie na bieżąco przeanalizować tego, co pokazują. Człowiek nie wytrzyma wielogodzinnego wpatrywania się w kilkadziesiąt ekranów, a zmęczenie operatora powoduje, że realnie monitorowane jest tylko to, co głośne i oczywiste. Systemy monitoringu wizyjnego z AI mają właśnie w tym miejscu wchodzić do gry: wyłapać anomalię, oznaczyć ją jako zdarzenie i przekazać operatorowi w możliwie prosty sposób.

Filozofia zmienia się z „wszystko nagraj, potem się znajdzie” na „wykryj odchylenie od normy, poinformuj człowieka i zapisz kontekst”. Zamiast godzin szukania krótkiego fragmentu z incydentem, system podaje konkretne momenty: wejście do strefy, w której nie powinno być ludzi, zatrzymanie pojazdu w niedozwolonym miejscu, leżącą osobę w magazynie czy próbę manipulacji przy drzwiach serwerowni.

W praktyce różnica jest szczególnie widoczna w centrach monitoringu. W tradycyjnym podejściu operator siedzi przed ścianą ekranów, z których każdy transmituje obraz z innej kamery. Po godzinie uwaga spada, drobne zdarzenia przechodzą niezauważone, a system staje się „teatrem bezpieczeństwa”. W wersji z AI operator widzi głównie lista alarmów i zdarzeń, a obraz z kamer pojawia się w trybie powiększonym tylko tam, gdzie algorytm wykrył problem. Kamery nadal nagrywają, ale priorytet mają te, które właśnie „zgłosiły rękę”.

Jedno z typowych wdrożeń w firmach logistycznych pokazuje to bardzo wyraźnie. Przed użyciem AI ochroniarze w nocy patrzyli na dziesiątki kamer obejmujących place składowe, rampy i parkingi. Większość czasu nic się nie działo, a drobne naruszenia – krótkie wejście w strefę załadowczą czy przestawienie palety w niedozwolone miejsce – pozostawały niezauważone. Po uruchomieniu analizy obrazu system zaczął generować wydarzenia: wykrycie osoby w strefie zastrzeżonej, przekroczenie wirtualnej linii przez pojazd, nietypowe zatrzymanie na rampie. Ochrona przestała grać rolę pasywnego obserwatora, a stała się dyspozytornią reagującą na konkretne sygnały.

Sęk w tym, że sama obecność „AI” w folderze handlowym niczego nie gwarantuje. Rzeczywistą zmianę daje dopiero połączenie technologii z dopracowanymi procedurami: określonym czasem reakcji, przypisaniem odpowiedzialności, sposobem dokumentowania i analizowania alarmów. Dopiero wtedy monitoring wizyjny z AI przestaje być gadżetem, a staje się jednym z kluczowych narzędzi bezpieczeństwa firmy.

Co AI faktycznie „widzi” w obrazie – pragmatyczne spojrzenie na technologię

Kluczowe funkcje analityki wizyjnej

Tradycyjne systemy CCTV oferowały proste wykrywanie ruchu: jeśli w pikselach obrazu pojawi się zmiana, generuj alarm. Brzmi rozsądnie, ale skutkuje lawiną fałszywych powiadomień – deszcz, cienie, liście na wietrze, światła samochodów. Prawdziwa analityka wizyjna z uczeniem maszynowym idzie krok dalej: próbuje zrozumieć, co się porusza, a nie tylko że się porusza.

Współczesne algorytmy potrafią rozpoznać podstawowe typy obiektów: człowiek, pojazd, rower, bagaż, a nawet bardziej specyficzne kategorie, jak wózek widłowy czy kask ochronny. Dzięki temu możliwe jest tworzenie inteligentnych reguł: alarmuj tylko, gdy człowiek pojawi się w wyznaczonej strefie poza godzinami pracy albo gdy pojazd zatrzyma się w miejscu „tylko do wysiadania”. To radykalnie zmniejsza liczbę fałszywych alarmów i pozwala operatorowi skupić się na zdarzeniach istotnych biznesowo.

Bardziej zaawansowane funkcje obejmują rozpoznawanie twarzy, odczyt tablic rejestracyjnych (LPR/ANPR), identyfikację elementów ubioru (np. brak kamizelki odblaskowej w strefie BHP) czy analizę zachowań. To ostatnie bywa nadużywane marketingowo, ale realnie przydaje się do wykrywania wzorców typu: długotrwałe błąkanie się w okolicy kasy, nagłe bieganie w strefie załadunkowej, grupowanie się osób w miejscu zwykle pustym.

W praktyce widać kilka stabilnych zastosowań:

- ochrona perymetryczna – system „widzi”, czy granicę terenu przekracza człowiek czy kot,

- kontrola dostępu pojazdów – tablice rejestracyjne są automatycznie dopasowywane do listy uprawnionych,

- bezpieczeństwo pracy – analiza, czy ludzie poruszają się w wyznaczonych korytarzach i czy używają środków ochrony.

Większy sceptycyzm przydaje się przy deklaracjach typu „analiza emocji na twarzy klienta” czy „rozpoznawanie zamiaru kradzieży po mowie ciała”. Część takich funkcji istnieje w laboratoriach, ale ich skuteczność w realnych warunkach handlu czy produkcji bywa dramatycznie niższa niż w reklamach. Zanim firma oprze na nich poważne decyzje (np. interwencje ochrony), warto je sprawdzić na własnym materiale.

Skąd się bierze „inteligencja” – od danych do działania

Modele sztucznej inteligencji do analizy obrazu są trenowane na ogromnych zbiorach danych – milionach zdjęć i nagrań. Uczą się rozpoznawać wzorce: ludzka sylwetka, kształt samochodu, charakterystyczne cechy tablicy rejestracyjnej. Problem w tym, że takie dane są zazwyczaj ogólne: osoby w różnych ubraniach, miasta z całego świata, różne pory dnia i roku. Gdy system trafia do konkretnej firmy, zderza się z inną rzeczywistością: specyficzne oświetlenie, powtarzalne uniformy, niski kontrast, refleksy w szybach.

Dlatego obok „modelu ogólnego” często potrzeba dostrojenia do obiektu. Czasem oznacza to konfigurację: wyznaczenie stref i linii, określenie godzin pracy, kalibrację wrażliwości. W bardziej zaawansowanych wdrożeniach wykorzystuje się dodatkowe dane z obiektu – nagrania z konkretnych kamer, które służą operatorom po stronie dostawcy do poprawy skuteczności rozpoznawania. Im bardziej powtarzalne i poważne są wymagania (np. krytyczna infrastruktura), tym większy sens ma taki proces.

Kluczową rolę odgrywa jakość obrazu. Sztuczna inteligencja nie robi cudów z zaszumioną, prześwietloną kamerą ustawioną pod złym kątem. Zbyt szerokie pole widzenia, nocne sceny bez doświetlenia, kamera patrząca „pod słońce” – to typowe powody, dla których nawet dobry algorytm zaczyna się mylić. Czasem najskuteczniejszą drogą podniesienia skuteczności AI jest nie zakup „lepszego modułu”, ale:

- zmiana lokalizacji kamery,

- dodanie źródła światła,

- zmniejszenie kąta widzenia, aby obiekty były większe w kadrze,

- przestawienie ostrości i ekspozycji.

Popularna rada „kup system z najlepszym algorytmem, a wszystko zadziała” nie sprawdza się w obiektach z trudnymi warunkami – ciemnymi parkingami, halami z dużą ilością pyłu czy szkła. W takich miejscach najpierw opłaca się uporządkować infrastrukturę: przeprojektować rozmieszczenie i parametry kamer, zrobić testowe nagrania, sprawdzić, czy ludzkie oko widzi to, co ma widzieć algorytm. AI jest tu ostatnim ogniwem, nie pierwszym.

Praktyczny sposób podejścia: wybrać 2–3 najbardziej krytyczne kamery (np. wejście do magazynu wysokiego składowania, wjazd na teren firmy, brama towarowa) i przetestować na nich różne ustawienia oraz funkcje analityki. Dopiero na tej podstawie skalować system dalej. Takie ostrożne, iteracyjne wdrożenie często oszczędza bardzo kosztownych rozczarowań.

Typy rozwiązań AI w monitoringu: od sprytnej kamery po system korporacyjny

AI w kamerze, rejestratorze czy w chmurze – trzy architektury

Za hasłem „monitoring wizyjny z AI” kryją się różne architektury techniczne. To, gdzie faktycznie odbywa się analiza obrazu, ma wpływ na koszty, niezawodność, cyberbezpieczeństwo i możliwość rozbudowy systemu. W praktyce stosuje się trzy główne podejścia:

| Model | Gdzie działa AI | Mocne strony | Ograniczenia |

|---|---|---|---|

| Edge (w kamerze) | Na procesorze kamery IP | Niskie obciążenie sieci, szybka reakcja, brak potrzeby mocnego serwera | Ograniczona moc obliczeniowa, trudniejsza rozbudowa o nowe funkcje |

| Serwer / NVR | Na lokalnym rejestratorze lub serwerze | Lepsza skalowalność, możliwość zaawansowanych algorytmów | Większe wymagania wobec sieci i sprzętu |

| Chmura | Na zewnętrznych serwerach dostawcy | Szybkie wdrożenie, aktualizacje po stronie dostawcy, łatwe testy | Wymóg stabilnego łącza, kwestie prywatności i zgodności z prawem |

W modelu edge kamera sama analizuje obraz, a do rejestratora lub systemu zarządzającego wysyła jedynie metadane (np. informację o zdarzeniu) i w razie potrzeby fragment nagrania. To zmniejsza obciążenie sieci, a reakcje są bardzo szybkie. Model ten sprawdza się w rozproszonych lokalizacjach (np. sieć sklepów), gdzie trudno stawiać mocne serwery w każdym punkcie. Problem pojawia się, gdy firma chce dodać nowy typ analityki – starsze modele kamer często nie pozwalają na aktualizację algorytmów.

W modelu z serwerem lokalnym lub rejestratorem NVR obraz z wielu kamer trafia do centralnego urządzenia, gdzie działa „silnik” AI. To podejście typowe dla większych zakładów i biurowców. Daje znaczną elastyczność: jedna, mocna maszyna wykonuje analizę, można stosunkowo łatwo zmieniać algorytmy, rozbudowywać liczbę kamer, integrować system z innymi narzędziami (kontrola dostępu, BMS, systemy IT). Wymaga jednak odpowiedniej przepustowości sieci oraz zabezpieczenia serwera przed atakami – w końcu staje się on krytycznym punktem infrastruktury.

Trzeci wariant to chmura. Obraz (zwykle w formie strumienia lub próbek) wysyłany jest do zewnętrznego centrum danych, gdzie działa analityka AI. Ten model kusi prostotą startu – wystarczy podłączyć kamery do internetu i skonfigurować konto u dostawcy. Jest wygodny w testach, pilotażach, a także w małych firmach, które nie mają działu IT. Z drugiej strony oznacza przesyłanie wrażliwych nagrań poza organizację, co wymaga przemyślenia kwestii prawnych, bezpieczeństwa danych i kontroli nad tym, kto ma dostęp do materiału.

Gotowe moduły a systemy „szyte na miarę”

Na rynku można spotkać dwa skrajne podejścia. Pierwsze to pudełkowe moduły analityki: kupujesz rejestrator lub licencję, wybierasz z listy funkcje („ochrona perymetrii”, „wykrywanie sabotażu kamery”, „liczenie osób”) i konfigurujesz je samodzielnie lub z pomocą instalatora. Drugie to rozwiązania projektowane indywidualnie, gdzie dostawca analizuje procesy firmy, dobiera kamery, tworzy reguły, integruje system z innymi narzędziami, a czasem nawet trenuje dedykowany model AI pod specyficzne scenariusze.

Kiedy wystarczy „pudełko”, a kiedy potrzebny jest projekt

Na pierwszy rzut oka podejście pudełkowe kusi prostotą: lista funkcji, kilka kliknięć, parę suwaków czułości i system „działa”. Ten model jest sensowny tam, gdzie:

- scenariusze są powtarzalne – np. sieć podobnych sklepów, parków logistycznych czy myjni,

- dopuszczalne są okresowe fałszywe alarmy (ważniejsza jest ogólna poprawa niż perfekcja),

- ochrona i dział techniczny są gotowe samodzielnie eksperymentować z ustawieniami.

Popularna rada „kup gotowy moduł, nie komplikuj projektu” łamie się przy obiektach o niestandardowej geometrii lub procesach. Hala z ruchomymi regałami, zakład chemiczny z dużą liczbą stref o różnym reżimie bezpieczeństwa, kampus z wieloma wejściami dla różnych typów użytkowników – tam prosty zestaw reguł z pudełka zaczyna się plątać. Operatorzy dostają dziesiątki sprzecznych powiadomień, a każdy wyjątek trzeba omijać „ręcznymi” konfiguracjami.

Rozwiązanie projektowe ma sens, gdy:

- system ma wpływać na kluczowe procesy biznesowe (np. przepływ towarów, bezpieczeństwo prac przy maszynach),

- w grę wchodzi integracja z istniejącymi systemami (ERP, WMS, HR, kontrola dostępu),

- liczba scenariuszy alarmowych jest duża i zróżnicowana, a reguły proste typu „przekroczenie linii” niewiele wnoszą,

- organizacja chce długofalowo rozwijać ekosystem analityki, nie tylko „dokleić moduł do rejestratora”.

Zaskakująco często sensownym kompromisem jest model mieszany: standardowe moduły do perymetrii, liczenia osób czy wykrywania sabotażu + 1–2 niestandardowe scenariusze opracowane wspólnie z integratorem. Taki układ pozwala uniknąć kosztów pełnego „szycia na miarę”, a jednocześnie adresuje to, co faktycznie odróżnia daną firmę od reszty rynku.

Licencje, subskrypcje i „koszty ukryte”

Przy planowaniu budżetu monitoringowego z AI więcej problemów generują licencje niż same kamery. Powszechna rada „weź subskrypcję, będzie taniej na start” pomija fakt, że system bezpieczeństwa żyje 7–10 lat, a nie 12 miesięcy. W takim horyzoncie czasowym nagle okazuje się, że:

Na koniec warto zerknąć również na: Monitoring w handlu detalicznym – od kamer do analizy zachowań klientów. — to dobre domknięcie tematu.

- koszt licencji per kanał kamery rośnie wraz z dodawaniem funkcji,

- upgrade do nowej wersji algorytmów bywa płatny, a stara linia produktów „zamraża się” technologicznie,

- modele chmurowe doliczają opłaty za ruch sieciowy, przechowywanie nagrań, integracje API.

Jeśli firma nie planuje dynamicznej rozbudowy funkcji analitycznych, często bardziej opłaca się klasyczny model: wyższy koszt początkowy za licencje wieczyste na kluczowe funkcje + wsparcie utrzymaniowe. Subskrypcja ma sens tam, gdzie scenariusze i wymagania będą się zmieniać – np. sieć sklepów testująca różne formaty, inwestor parków magazynowych dopasowujący funkcje do kolejnych najemców, operator centrum danych rozwijający polityki bezpieczeństwa.

Do kosztów ukrytych dochodzi jeszcze jeden element: czas ludzi. Każdy nowy moduł AI trzeba nie tylko skonfigurować, ale potem utrzymywać: reagować na fałszywe alarmy, poprawiać strefy, dostosowywać do zmian w aranżacji przestrzeni. Jeśli w kalkulacji opłacalności nie pojawia się czas pracy operatorów i techników, rachunek bywa myląco optymistyczny.

Jak AI zmienia codzienną pracę ochrony i działu bezpieczeństwa

Od „patrzenia w monitory” do zarządzania wyjątkami

Najbardziej praktyczna zmiana nie dotyczy samej technologii, tylko sposobu pracy. Klasyczny wzorzec: operatorzy siedzą przed ścianą monitorów i „obserwują”, czy coś się dzieje. W rzeczywistości po kilkunastu minutach uwaga spada, a realna detekcja opiera się na przypadkowych spojrzeniach. AI podmienia ten model na pracę na zdarzeniach.

Typowy dzień w nowym układzie wygląda inaczej: system generuje listę alertów z opisem („wejście do strefy A poza harmonogramem”, „zatrzymanie osoby na klatce schodowej ponad 5 minut”, „pojazd bez uprawnień na wjeździe 3”), a operator porusza się po tej kolejce, potwierdzając lub odrzucając zdarzenia. Monitory z podglądem „ciągłym” stają się tłem, a głównym narzędziem są panele zdarzeń i metadane.

Taki model wymusza inną organizację:

- ważniejsza staje się jakość konfiguracji reguł niż liczba kamer,

- czas reakcji jest mierzony od momentu powiadomienia, a nie od „wykrycia wzrokiem”,

- logi z pracy operatorów (kto, kiedy, jak zaklasyfikował zdarzenie) stają się cennym źródłem do poprawy algorytmów i procedur.

Firma, która oczekuje, że „AI poprawi bezpieczeństwo”, a nie zmieni nic w organizacji pracy dyżurki, dostaje zwykle jedynie nową warstwę powiadomień, które lądują w tym samym koszu „przeładowania informacją”.

Redukcja fałszywych alarmów – czyli mniej telefonów w nocy

Dla ochrony kluczową miarą jakości systemu są nie tyle „wychwycone zdarzenia”, ile fałszywe alarmy. To one psują czujność ludzi. Popularne hasło sprzedażowe: „AI redukuje fałszywe alarmy o 90%” ma sens tylko wtedy, gdy wiemy, od jakiego poziomu startujemy. Jeśli kamera nad ruchliwą ulicą generowała 200 alarmów na noc, a po wdrożeniu AI zostaje 20, nadal oznacza to 20 niepotrzebnych interwencji.

Sensownie skonfigurowany system wykorzystuje kilka prostych technik:

- klasyfikację obiektów – odróżnianie człowieka od zwierzęcia czy pojazdu,

- kontekst czasowy – inne progi i reguły w godzinach pracy, inne w nocy i weekendy,

- kontekst przestrzenny – różne zasady dla stref „brzegowych” (np. chodnik przed ogrodzeniem) i wnętrza obiektu,

- fuzję sensorów – połączenie obrazu z AI z klasycznymi czujkami (PIR, kontaktrony, bariery).

W praktyce najlepsze efekty daje proste założenie: nie każda kamera musi mieć AI. Zamiast próbować „uszczęśliwić” cały obiekt analityką, lepiej dobrać 10–20% krytycznych punktów, na których fałszywe alarmy są najbardziej dotkliwe (np. ogrodzenie od strony ruchliwej ulicy, wjazd na parking ciężarowy, tylne wejście do magazynu) i tam dociążyć system dodatkowymi warstwami logiki.

W tym miejscu przyda się jeszcze jeden praktyczny punkt odniesienia: Jak zmienią się cyberataki w dobie komputerów kwantowych?.

Nowe kompetencje w zespole bezpieczeństwa

AI zmienia też skład i zadania zespołu. Zamiast wyłącznie „ludzi od ochrony” pojawia się potrzeba ról bardziej technicznych i analitycznych. Zazwyczaj wyróżniają się trzy obszary:

- operatorzy pierwszej linii – obsługa bieżących alertów, praca z interfejsem systemu, podstawowe decyzje (fałszywy / prawdziwy alarm),

- koordynatorzy bezpieczeństwa – definiowanie reguł, scenariuszy reakcji, analiza trendów zdarzeń w czasie,

- administrator / „właściciel systemu” – integracje techniczne, kontakt z dostawcą, pilnowanie aktualizacji i konfiguracji, podstawowa analityka danych.

Typowy błąd to założenie, że wszystkiego przypilnuje integrator zewnętrzny. O ile przy wdrożeniu ma to sens, o tyle przy codziennej pracy brak wewnętrznego właściciela systemu skutkuje tym, że po kilku miesiącach nikt nie pamięta, które alerty są istotne, a które kiedyś „tymczasowo” wyłączono. W efekcie system stopniowo traci skuteczność, choć technicznie działa poprawnie.

Przykład z praktyki: w jednym z magazynów wysokiego składowania zespół ochrony zgłaszał, że „AI się nie sprawdza”. Analiza logów pokazała, że większość ważnych alertów była ręcznie oznaczana jako fałszywe, bo zespół nie miał jasno opisanych scenariuszy reakcji dla nowych typów zdarzeń (np. dłuższe przebywanie w strefach mniej oczywistych). Po doprecyzowaniu procedur i krótkim szkoleniu liczba błędnych klasyfikacji spadła drastycznie – bez zmiany algorytmu.

Współpraca z innymi działami: HR, BHP, operacje

Monitoring z AI przestaje być wyłącznie domeną „ochrony fizycznej”. Dane z kamer zaczynają interesować:

- BHP – analiza używania środków ochrony indywidualnej, ruchu w korytarzach ewakuacyjnych, zachowania odległości od stref niebezpiecznych,

- HR – kontrola nadużyć czasu pracy (np. powtarzalne, długie przerwy w tych samych strefach), analiza obciążenia recepcji czy punktów obsługi,

- operacje / logistyka – optymalizacja ruchu wózków, kontrola kolejek na rampach, wykrywanie wąskich gardeł.

Brzmi atrakcyjnie, ale generuje też konflikt interesów. To, co dla logistyki jest „cenną metryką operacyjną”, dla działu HR i związków zawodowych może być agresywną formą nadzoru. W realnych projektach wiele pomysłów zatrzymuje się nie na technologii, ale na akceptowalności społecznej i zgodności z prawem pracy oraz RODO.

Rozsądna praktyka polega na tym, aby:

- osobno zdefiniować zastosowania stricte bezpieczeństwa (ochrona życia, zdrowia, majątku),

- osobno – ewentualne zastosowania „produktywnościowe”,

- dla każdej grupy jasno opisać, jakie dane są zbierane, jak długo są przechowywane i kto ma do nich dostęp,

- włączać przedstawicieli pracowników w dyskusję o nowych funkcjach, zanim zostaną wdrożone na szeroką skalę.

Dział bezpieczeństwa, który samodzielnie „przepycha” projekty AI w imię ochrony, szybko traci zaufanie innych działów. Tymczasem wiele cennych zastosowań jest możliwych właśnie dlatego, że pracownicy rozumieją, po co system istnieje i gdzie są granice jego użycia.

Zastosowania, które naprawdę się sprawdzają – i te, które na razie zawodzą

Scenariusze „nudne, ale skuteczne”

Najbardziej efektywne są zwykle te zastosowania, które rzadko trafiają na slajdy sprzedażowe. Nie ma w nich efektu „science fiction”, ale za to działają stabilnie w różnych obiektach. Najczęściej są to:

- ochrona przedwłamaniowa po godzinach pracy – wzmocnienie klasycznych czujek detekcją ludzi w video, redukcja fałszywych alarmów spowodowanych zwierzętami, liśćmi czy światłami przejeżdżających pojazdów,

- kontrola wjazdów – powiązanie odczytu tablic z bazą uprawnionych, automatyczne otwarcie szlabanów, generowanie dzienników wejść dla ochrony i administracji,

- monitorowanie ruchu w strefach krytycznych – maszynownie, rozdzielnie, magazyny wysokiego składowania, gdzie liczy się czas reakcji na obecność nieuprawnionej osoby.

Te scenariusze mają kilka cech wspólnych: wyraźnie zdefiniowana strefa, mało dwuznacznych zachowań, relatywnie prosta logika („człowiek tam, gdzie nie powinno go być”). Dzięki temu algorytmy mogą pracować stabilnie, a konfiguracja nie wymaga codziennych korekt.

Bezpieczeństwo pracy – sukcesy i pułapki

Drugi obszar z realnym potencjałem to bezpieczeństwo pracy. AI potrafi wykryć brak kasku, kamizelki, czasem nawet okularów ochronnych. Może też sygnalizować wejście człowieka w obrys pracy maszyny czy zbyt bliską jazdę wózka przy krawędzi rampy.

Problem pojawia się, gdy z takich funkcji próbuje się zrobić system „karzący”. Jeśli każdy wykryty brak kasku kończy się oficjalną reprymendą, ludzie zaczynają szukać sposobów obejścia systemu (np. noszą kask tylko „pod kamerą”, resztę czasu pracując bez zabezpieczenia). Dużo lepsze efekty daje podejście, w którym:

- AI generuje metryki zbiorcze (ile razy miesięcznie wystąpił brak wyposażenia ochronnego w danej strefie),

- w pierwszym etapie dane służą do identyfikacji problematycznych procesów, a nie poszczególnych osób,

- zmiany wprowadza się głównie przez modyfikacje organizacji pracy (np. inne rozmieszczenie szafek z wyposażeniem, zmiana kolejności czynności), a nie wyłącznie przez sankcje.

AI staje się wtedy narzędziem do diagnozowania systemowych problemów, a nie kolejnym „batem”. Dla wielu firm to jedyna droga, by połączyć realną poprawę bezpieczeństwa z akceptacją załogi.

Detekcja kradzieży i „podejrzanych zachowań” – miejsce, gdzie reklama rozjeżdża się z rzeczywistością

Dlaczego automatyczna „detekcja kradzieży” tak często zawodzi

Sprzedażowe prezentacje obiecują system, który „rozpoznaje złodzieja po zachowaniu”. Rzeczywistość jest bardziej przyziemna: obecne algorytmy radzą sobie głównie z prostymi wzorcami, takimi jak wynoszenie niezeskanowanego towaru poza linię kas czy wejście w strefę „tylko dla personelu”.

Największy problem to kontekst. Dla algorytmu klient długo oglądający ten sam regał może wyglądać jak osoba „czająca się”, ale w praktyce równie dobrze może porównywać etykiety. Z kolei typowe „kradzieże zawodowe” są realizowane w sposób tak płynny i zgrany, że nawet doświadczony ochroniarz nie widzi nic nietypowego – tym bardziej nie zobaczy tego uogólniony model zachowań.

Dobrze działają natomiast scenariusze oparte na twardych regułach:

- wyjście z magazynu z paczką bez uprzedniego zeskanowania jej w systemie WMS,

- przejście przez linię kas z wózkiem, którego wartość z paragonu rażąco odbiega od „typowego koszyka” (analityka transakcyjna + wideo),

- próba otwarcia drzwi lub bramy z zastrzeżonej strefy poza zdefiniowanymi oknami czasowymi.

Te scenariusze nie „czytają w myślach” złodzieja. Łączą po prostu zdarzenia biznesowe (skanowanie, logowania, otwarcia zamków) z tym, co widać na kamerach. Prawdziwa detekcja nadużyć powstaje więc często nie w kamerze, ale w warstwie integracji systemów.

Popularna rada brzmi: „najpierw zróbmy detekcję kradzieży w sklepach, potem rozszerzymy na inne obszary”. Odwrócenie kolejności bywa rozsądniejsze. Z dużo mniejszym ryzykiem reputacyjnym i prawnym można zacząć od stref zamkniętych (magazyny, rampy, wyjścia techniczne), gdzie jest mniej osób, mniej wyjątków i łatwiej zdefiniować jasne reguły. Dopiero gdy tam zespół opanuje pracę z alertami, można myśleć o bardziej miękkich scenariuszach, typu „podejrzane zachowanie klienta”.

Analiza zachowań a ryzyko dyskryminacji

Szczególnie śliskim obszarem są wszystkie funkcje, które wiążą obraz z cechami człowieka: wiekiem, płcią, a czasem pochodzeniem etnicznym. Nawet jeśli dostawca przekonuje, że „model nie rozpoznaje rasy, tylko wzorce ruchu”, w praktyce można łatwo wejść w obszar dyskryminacji pośredniej.

Klasyczny przykład: system uczy się na historycznych danych, gdzie ochrona częściej przyglądała się młodym mężczyznom w bluzach z kapturem. Algorytm zaczyna „wzmacniać” ten wzorzec, podnosząc ryzyko alertów dla tej grupy. Formalnie nikt nie wpisał „profiluj młodych mężczyzn”, ale efekt końcowy jest podobny.

Rozsądniejsze podejście to ograniczanie się do obserwowalnych zachowań niezwiązanych z cechami osobistymi, np.:

- poruszanie się „pod prąd” względem typowego ruchu w sklepie czy magazynie,

- wielokrotne wejścia i wyjścia z tej samej strefy bez jasnego powodu operacyjnego,

- próby manipulacji fizycznymi zabezpieczeniami (zamykanie/otwieranie bramek, blokowanie drzwi).

Kluczowy test praktyczny: czy dana reguła alertu da się zapisać bez użycia kategorii osoby? Jeśli nie – lepiej traktować ją co najwyżej jako sugestię do ręcznej analizy, a nie pełnoprawny „dowód” czy wyzwalacz sankcji.

AI w małych i średnich firmach – kiedy to ma sens

Wiele mniejszych firm słyszy komunikat: „AI w kamerach jest już standardem, nie zostań w tyle”. Problem w tym, że standardy dużego retailu czy logistyki nie przekładają się wprost na magazyn rodzinnej hurtowni albo małą fabrykę.

Prosty filtr decyzyjny może wyglądać tak:

- liczba incydentów – jeśli przez ostatnie dwa lata nie było żadnego realnego włamania, a większość zgłoszeń to drobne nieporozumienia, inwestycja w zaawansowaną analitykę „per kamera” prawdopodobnie się nie zwróci,

- koszt reakcji – im droższa każda niepotrzebna interwencja (dojazd patrolu, zatrzymanie linii produkcyjnej), tym większy sens ma inwestowanie w redukcję fałszywych alarmów,

- powtarzalność scenariuszy – jeśli obiekt „żyje” bardzo różnie z dnia na dzień, konfiguracja reguł AI będzie wymagała stałego dłubania; jeśli dominują powtarzalne sytuacje (np. te same okna czasowe, te same trasy ruchu), system ma szansę działać stabilnie.

Paradoksalnie, dla wielu małych firm rozsądniejszym pierwszym krokiem niż zakup „inteligentnych kamer” jest uporządkowanie prostych rzeczy: poprawa oświetlenia, czytelne oznaczenie stref, przemyślane kadrowanie istniejących kamer, a dopiero potem dokładanie analityki tam, gdzie oczywiście brakuje ludzi do reakcji.

Popularna rada z rynku brzmi: „weź gotowe, chmurowe AI, nie potrzebujesz nic planować”. To działa, gdy obiekt jest stosunkowo prosty (np. jedna hala, kilka wjazdów) i nie ma ostrych wymogów prawnych. W przypadku firm produkcyjnych, magazynów z materiałami niebezpiecznymi czy zakładów infrastruktury krytycznej, taki „plug and play” rzadko wytrzymuje zderzenie z realnymi procedurami bezpieczeństwa i kontrolami regulatorów.

Chmurowe analityki vs. systemy lokalne

Rozwiązania AI w monitoringu można dziś podzielić na dwa główne nurty: analityka w chmurze oraz analityka on-premise (na lokalnych serwerach lub wręcz w samej kamerze). Każde z nich ma swoje nieoczywiste konsekwencje.

Chmura kusi prostotą: aktualizacje modeli, skalowanie mocy obliczeniowej, dostęp „z każdego miejsca”. Ukryty koszt pojawia się przy:

- przepływie danych – wysyłanie wielu strumieni HD do chmury generuje koszty łącza i opóźnienia,

- jurysdykcji – dane video często nie mogą opuszczać określonego kraju czy strefy prawnej, szczególnie w sektorach regulowanych,

- uzależnieniu od dostawcy – zmiana pricingu lub polityki przechowywania danych potrafi w kilka miesięcy „zjeść” finansowy sens całego projektu.

Z kolei systemy lokalne wymagają większej inwestycji na starcie (serwery, konfiguracja, utrzymanie), ale dają pełniejszą kontrolę nad tym, co dzieje się z nagraniami i modelami. W praktyce coraz częściej wygrywa hybryda:

- podstawowe, wrażliwe funkcje (ochrona perymetryczna, strefy krytyczne) działają lokalnie,

- bardziej „eksperymentalne” analityki (np. liczenie kolejek, analiza wykorzystania przestrzeni biurowej) są realizowane w chmurze, często z odanonimizowanym obrazem lub danymi pośrednimi.

Pułapka polega na tym, że firmy często zaczynają od „małego eksperymentu” w chmurze, który z czasem urasta do krytycznego elementu systemu bezpieczeństwa – bez formalnego przejścia przez ocenę ryzyka, DPIA czy przegląd umów. Dobrą praktyką jest formalne oznaczenie, które komponenty mają status „produkcyjny”, a które są tylko „pilotażem” i mogą zostać wyłączone bez paraliżu ochrony.

Jakość danych i „brudny” obraz z kamer

W większości projektów nie największym ograniczeniem jest sam algorytm, tylko jakość obrazu. Stare kamery, przypadkowe kąty widzenia, przepalone światłem strefy wejściowe – to wszystko sprawia, że nawet najlepsza sieć neuronowa „widzi” z grubsza to, co człowiek na mocno rozmytym, prześwietlonym zdjęciu.

Szereg „magicznych” obietnic typu: „nasz model radzi sobie nawet przy słabym oświetleniu” zawodzi przy zderzeniu z halą, gdzie o 3 w nocy widoczność przypomina niemal całkowitą ciemność, a jedynym źródłem światła są migające lampy maszyn. Zamiast dosypywać kolejne warstwy AI, często skuteczniejsze są proste inwestycje:

- dodatkowe oświetlenie stref newralgicznych (nawet kilka lamp LED może zmienić skuteczność detekcji),

- przestawienie kamer tak, aby nie filmowały wprost w kierunku słońca czy reflektorów,

- ujednolicenie typów kamer w obrębie jednej strefy, by analityka nie musiała „uśredniać” parametrów z bardzo różnych źródeł.

Popularny skrót myślowy: „damy AI, to naprawi złe kamery” działa tylko w bardzo ograniczonym zakresie. Przezroczyste refleksy na szybach, brudne kopuły czy wibracje masztów przy wietrze są dla algorytmu tak samo kłopotliwe jak dla człowieka. Z tego powodu sensowna polityka utrzymania (czyszczenie, przeglądy, testy nocne) bywa dla skuteczności AI ważniejsza niż kolejny „upgrade modelu” od dostawcy.

Integracja z kontrolą dostępu i systemami IT

Kiedy system video zaczyna być „inteligentny”, naturalnym krokiem jest powiązanie go z kontrolą dostępu (KD) i systemami IT. Sam obraz niewiele mówi o tym, czy dana osoba „ma prawo” być w danej strefie – tę odpowiedź trzymają logi kart, kont domenowych czy systemów produkcyjnych.

Najbardziej praktyczne scenariusze to:

- weryfikacja tożsamości – porównanie osoby przy bramce z danymi z karty dostępu (niekoniecznie przez rozpoznawanie twarzy, czasem wystarcza porównanie liczby osób i liczby odbić kart, by wykryć „przemycanie” dodatkowych osób),

- śledzenie incydentów – gdy pojawia się zdarzenie w systemie KD (np. odmowa wejścia na kartę), video AI może oznaczyć nagranie jako istotne i powiązać je z profilem użytkownika w systemie bezpieczeństwa,

- automatyczne podnoszenie poziomu czujności – po wykryciu nieautoryzowanej próby logowania w systemach IT w nocy, analityka video może tymczasowo „podkręcić” czułość wybranych kamer w newralgicznych strefach.

Kontrariański element polega na tym, że zbyt głęboka integracja potrafi zablokować rozwój. Im więcej systemów musi „zagrać razem”, tym trudniej wprowadzać zmiany w jednym z nich (np. wymianę KD czy modernizację platformy IT). Dlatego sensowne jest projektowanie integracji jako luźno sprzężonych – przez pośrednie API, system SIEM lub warstwę pośrednią – zamiast prób zbudować jedną, monolityczną „platformę bezpieczeństwa wszystkiego”.

Jak AI zmienia nawyki projektantów i integratorów

Klasyczne projekty monitoringu zaczynały się od pytania: „gdzie powiesić kamery, żeby wszystko widzieć?”. W świecie z AI ważniejsze staje się: „jakie pytania system ma umieć sensownie zadać i na jakie odpowiedzi ma reagować?”. To przesuwa środek ciężkości z samego sprzętu na model procesów.

Jeśli działalność firmy wiąże się z dodatkowymi wymogami (np. dane medyczne, infrastruktura krytyczna, tajemnica przedsiębiorstwa), wybór architektury trzeba rozpatrywać wspólnie z działem prawnym i specjalistami od cyberbezpieczeństwa. Zagadnienia takie jak szyfrowanie transmisji, segmentacja sieci, uwierzytelnienie użytkowników czy aktualizacje oprogramowania kamer stają się równie ważne, jak sama jakość obrazu. Kto chce głębiej wejść w powiązanie nowych technologii z cyberbezpieczeństwem, znajdzie więcej o technologia w analizach specjalistycznych.

Konsekwencje są dość praktyczne:

- strefy projektuje się od razu z myślą o tym, co będzie „jednoznacznym naruszeniem” (np. specjalne pasy przy ogrodzeniu, wydzielone korytarze techniczne),

- rezygnuje się z „ładnych ujęć wszystkiego” na rzecz kilku dobrze zdefiniowanych kadrów, gdzie człowiek czy pojazd jest zawsze w miarę podobnej skali,

- częściej stosuje się eksperymenty A/B: dwa różne ustawienia kamer czy reguł AI na podobnych strefach, a po kilku miesiącach świadomy wybór tego, co faktycznie daje mniej fałszywych alarmów i szybszą reakcję.

Zmienia się też rola integratora. Od wykonawcy, który „zainstaluje i skonfiguruje”, oczekuje się coraz częściej roli partnera od danych. Ten, kto potrafi opisać, jakie metryki zbiera system, jak mierzyć skuteczność reguł, jak cyklicznie przeglądać alerty – ma przewagę nad tym, kto skupia się wyłącznie na parametrach technicznych kamer i serwerów.

Popularna porada „kup system u jednego producenta, będzie łatwiej” bywa prawdziwa przy prostych instalacjach. W złożonych środowiskach często lepiej działa model, w którym warstwa wideo jest od jednego dostawcy, ale warstwa analityki pozostaje możliwie otwarta (standardowe protokoły, API), tak aby dało się w przyszłości podmieniać lub dokładąć różne moduły AI bez wymiany całej infrastruktury.

Najczęściej zadawane pytania (FAQ)

Jak sztuczna inteligencja zmienia tradycyjny monitoring wizyjny w firmach?

AI przesuwa monitoring z roli „elektronicznej czarnej skrzynki” do systemu wczesnego ostrzegania. Zamiast tylko nagrywać obraz, algorytmy analizują go na bieżąco i wyłapują nietypowe zdarzenia: wejście do strefy zabronionej, długie zatrzymanie pojazdu w newralgicznym miejscu czy leżącą osobę w magazynie.

Operator nie musi już patrzeć w dziesiątki ekranów, z których większość przez cały dyżur „pokazuje nudę”. Dostaje listę konkretnych alarmów, a obraz z kamery powiększa się dopiero wtedy, gdy coś faktycznie się dzieje. Monitoring przestaje być teatrem bezpieczeństwa, a zaczyna działać jak dyspozytornia reagująca na sygnały.

Jakie funkcje analityki wizyjnej AI naprawdę działają w realnych warunkach?

Najbardziej sprawdzone są funkcje, które opierają się na prostym, ale solidnym rozpoznawaniu obiektów. System potrafi odróżnić człowieka od pojazdu, roweru czy zwierzęcia, a także śledzić, jak te obiekty poruszają się po scenie. Na tej podstawie można tworzyć reguły typu: alarm tylko wtedy, gdy człowiek wchodzi do wyznaczonej strefy poza godzinami pracy albo pojazd zatrzymuje się tam, gdzie nie powinien.

Stosunkowo dojrzałe są też: odczyt tablic rejestracyjnych (LPR/ANPR), rozpoznawanie twarzy w kontrolowanych warunkach oraz detekcja elementów ubioru (np. kask, kamizelka odblaskowa). Znacznie mniej stabilne w praktyce są funkcje „magiczne”, jak analiza emocji czy wykrywanie zamiaru kradzieży po mowie ciała – na to lepiej patrzeć jak na eksperyment, a nie fundament polityki bezpieczeństwa.

Czym różni się AI od zwykłego wykrywania ruchu w kamerach CCTV?

Klasyczne wykrywanie ruchu reaguje na każdą zmianę pikseli w obrazie – deszcz, cienie, falujące liście, refleksy świateł. Efekt to lawina fałszywych alarmów, które po kilku dniach i tak lądują w koszu, bo nikt nie jest w stanie ich sensownie obsłużyć. Sam fakt, że „coś się poruszyło”, niewiele mówi o realnym zagrożeniu.

AI próbuje odpowiedzieć na pytanie „co się poruszyło i w jakim kontekście”. Rozpoznaje kategorię obiektu, jego zachowanie i relację do wyznaczonych stref czy linii. Dzięki temu może np. ignorować przejazd samochodów ulicą za ogrodzeniem, a zareagować tylko wtedy, gdy człowiek przekroczy wirtualną linię na terenie firmy. To nie jest kwestia „mądrzejszego detektora ruchu”, tylko zupełnie innego poziomu filtracji sygnałów.

Czy każda firma potrzebuje „najlepszego algorytmu AI” do monitoringu?

Popularna rada „kup system z najlepszym algorytmem, a reszta się sama ułoży” brzmi atrakcyjnie, ale w wielu obiektach po prostu nie działa. Jeśli kamery są źle ustawione, scena jest niedoświetlona, a pole widzenia zbyt szerokie, nawet topowy model będzie generował błędy. AI nie naprawi fizyki: z zaszumionego, prześwietlonego obrazu nie wyciągnie wiarygodnych wniosków.

Rozsądniejsze podejście to: najpierw uporządkować infrastrukturę (lokalizacja kamer, oświetlenie, kąty widzenia), a dopiero potem dobierać algorytmy. W wielu firmach więcej daje przestawienie kilku kamer i dodanie światła przy bramie niż zmiana dostawcy AI. „Najlepszy algorytm” ma sens dopiero wtedy, gdy obraz jest technicznie dobry i powtarzalny.

Jak wdrożyć monitoring z AI, żeby nie skończyło się na drogim gadżecie?

Kluczowe jest połączenie technologii z procedurami. Sam fakt, że system generuje alarmy, nic nie zmienia, jeśli nie ma ustalonego: kto reaguje, w jakim czasie, jak dokumentuje zdarzenie i jak później są analizowane fałszywe i prawdziwe alarmy. Bez tego monitoring z AI pozostaje „fajnym ekranem w recepcji”, a nie narzędziem bezpieczeństwa.

Praktyczny model to wdrożenie krok po kroku. Najpierw 2–3 najbardziej krytyczne kamery (np. wjazd, brama towarowa, wejście do magazynu wysokiego składowania), test różnych ustawień i reguł, przegląd alarmów z kilku tygodni. Dopiero gdy w tym pilotażu powstanie sensowny zestaw procedur i progów czułości, można skalować system na kolejne strefy.

Jak poprawić skuteczność AI w istniejącym systemie monitoringu?

Zanim zamówi się „lepszy moduł analityki”, warto sprawdzić podstawy. Typowe proste kroki, które realnie podnoszą jakość rozpoznawania, to: zawężenie pola widzenia (żeby osoba nie była mikroskopijnym punktem w kadrze), korekta ostrości i ekspozycji oraz dodanie doświetlenia w nocy. Często wystarczy przestawić kamerę o kilkadziesiąt centymetrów, aby uniknąć patrzenia „pod słońce” czy wprost w reflektory.

Dopiero na tak poprawionym obrazie ma sens precyzyjniejsze dostrajanie algorytmu: konfiguracja stref, wirtualnych linii, godzin działania reguł czy poziomu czułości. W bardziej wymagających lokalizacjach dobrym ruchem jest przekazanie dostawcy kilkudniowych nagrań z konkretnych kamer, żeby dostroił modele do realnych warunków, a nie tylko do danych z katalogu treningowego.